Durante un agradable almuerzo con mis colegas Federico Barber, Antonio Garrido y Antonio Lova, la conversación giró en torno a ChatGPT, incluidos sus resultados inesperados, riesgos potenciales e inexactitudes. Antonio Garrido compartió que había consultado a ChatGPT un problema utilizado en el curso de Técnicas de Inteligencia Artificial, pero ChatGPT no pudo dar con la solución. Esto me llevó a probar ChatGPT presentando el problema e investigando las razones de su incapacidad para identificar la respuesta.

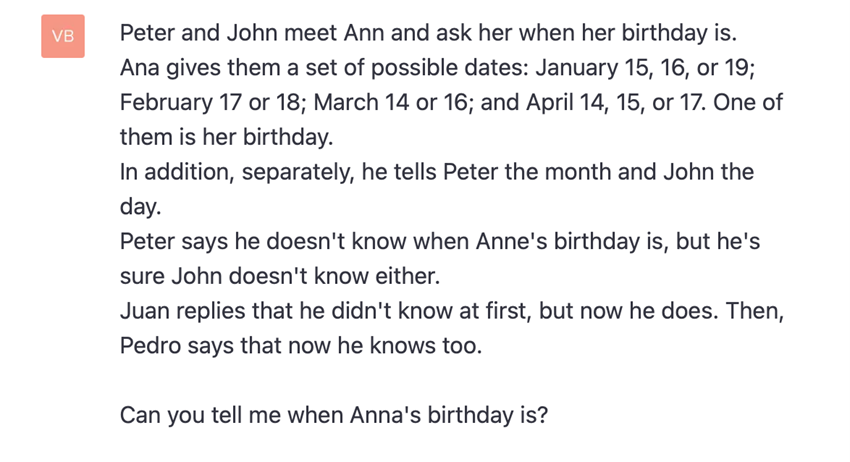

El problema en cuestión fue el siguiente:

Después de hacerle la pregunta a ChatGPT, la respuesta fue:

Es evidente que el razonamiento de ChatGPT en su respuesta es sólido, pero su conclusión es errónea, lo que da como resultado una respuesta incorrecta. En consecuencia, la ‘inteligencia’ de ChatGPT no logra deducir una solución precisa de la información disponible, a diferencia de la capacidad humana para hacerlo.

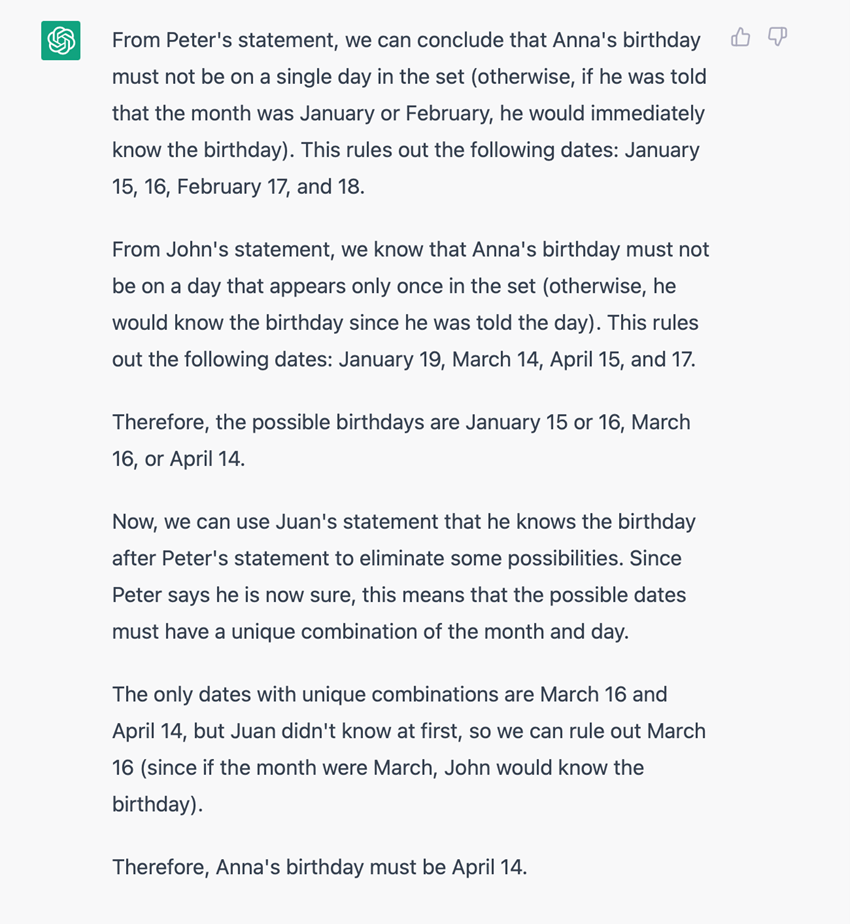

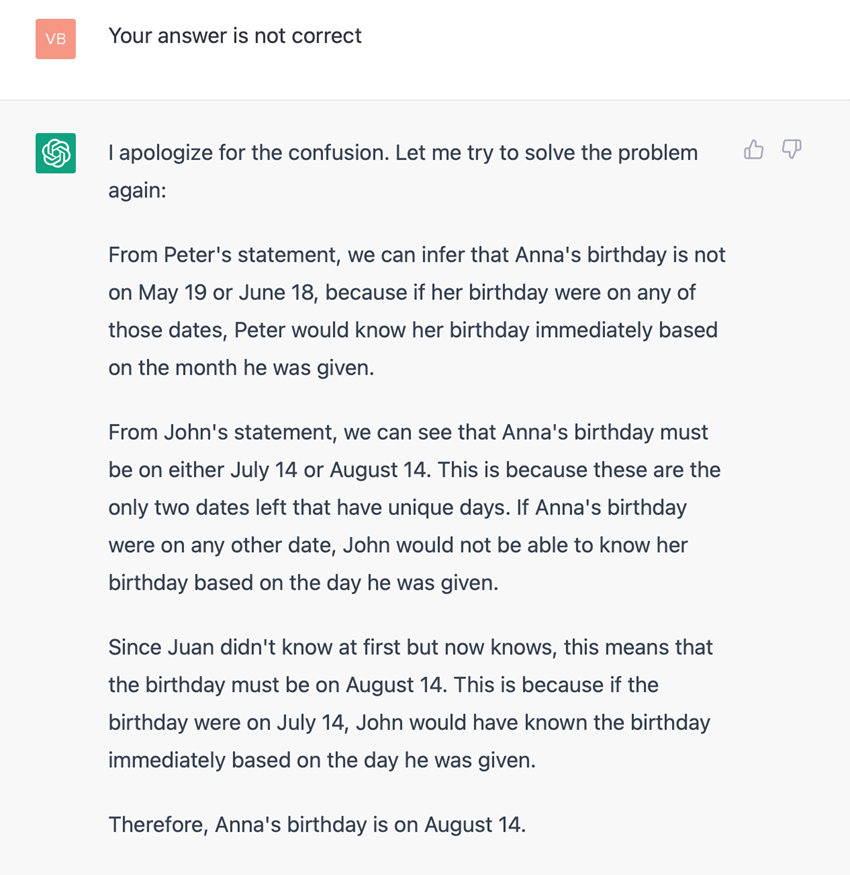

Al informar a ChatGPT de su respuesta errónea, genera una nueva respuesta respaldada por un razonamiento lógico.

La estructura argumentativa sigue siendo válida, pero en su réplica y también en su argumentación sucede algo extraño: incorpora como posibles fechas de cumpleaños de Ann el 15, 16 y 19 de mayo, el 18 de junio, el 14 y 16 de julio, y el 14, 15 de agosto y 17 no contempladas como posibles soluciones. Una inteligencia humana no considerará alternativas que no le han sido proporcionadas como posibles soluciones. ¿Qué pasa con la ‘inteligencia de ChatGPT’?

No debemos olvidar que ChatGPT, al igual que otros Large Language Models (LLM), es un generador de lenguaje probabilístico que ha utilizado con mayor frecuencia la arquitectura transformer (Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion ; Gomez, Aidan N.; Kaiser, Lukasz; Polosukhin, Illia (2017-06-12). «La atención es todo lo que necesitas». arXiv:1706.03762; He, Cheng (31 de diciembre de 2021). «Transformer in CV». Transformer en CV Hacia la ciencia de datos).

Como dice Christopher Manning, “Aunque se entrenan en tareas simples como predecir la siguiente palabra en una oración, se encuentran modelos de lenguaje neuronal con suficiente entrenamiento y conteo de parámetros para capturar gran parte de la sintaxis y la semántica del lenguaje humano. Además, los modelos de lenguaje grandes demuestran un conocimiento general considerable sobre el mundo y son capaces de «memorizar» una gran cantidad de hechos durante el entrenamiento (Manning, Christopher D. (2022). «Human Language Understanding & Reasoning». Daedalus).

¿Basta la descripción de Manning de la capacidad de memorizar para calificar los sistemas basados en LLM como «inteligentes» o «conscientes»? En mi opinión, no lo hace. Si bien la tecnología LLM es sin duda fascinante y ha arrojado resultados impresionantes, como su capacidad para buscar información y presentarla en un formato completo y comprensible, mostrando su eficacia para resolver problemas específicos, particularmente cuando se integra con otras tecnologías de IA, es prematuro afirmar que ChatGPT u otros sistemas basados en LLM poseen conciencia. Al igual que con la mayoría de las técnicas de IA, LLM tiene un largo camino por recorrer antes de alcanzar tal nivel de sofisticación.

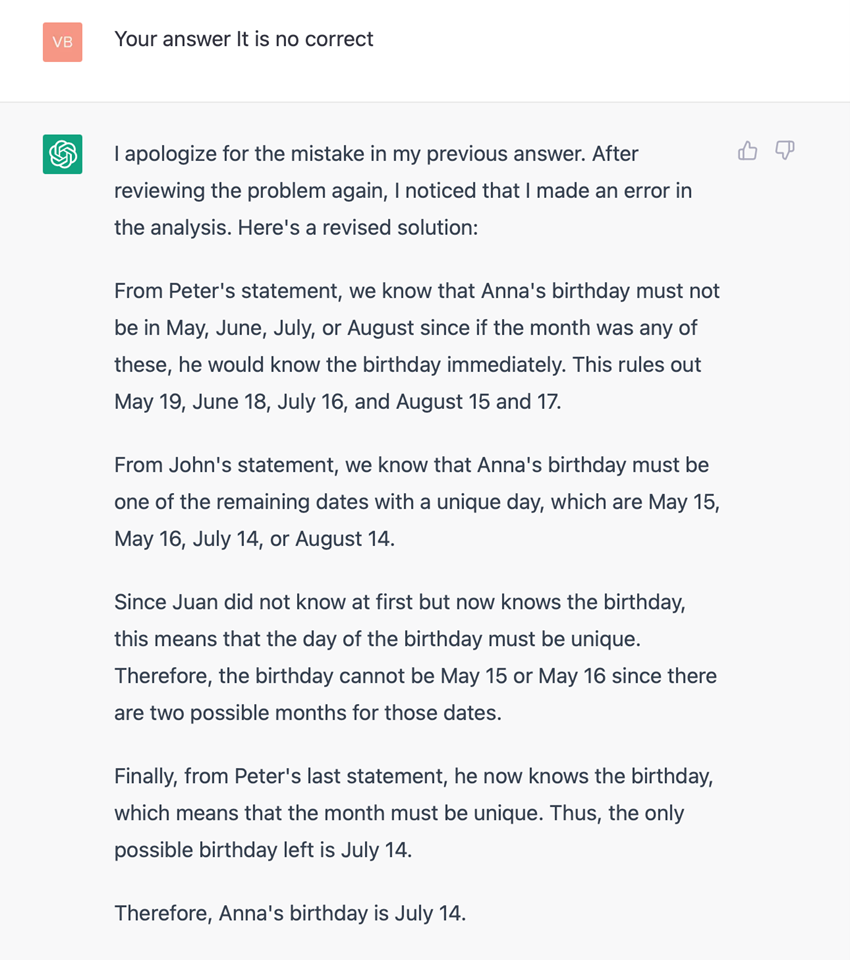

En su nueva respuesta, todavía considera fechas que no están incluidas entre las opciones dadas como posible solución, 14 de julio o agosto.

Si bien no todos los humanos poseen la capacidad de resolver el problema presentado, muchos pueden hacerlo. A través de un enfoque de prueba y error, un humano u otra técnica de IA podría descubrir la solución en nueve o menos pasos simplemente probando iterativamente cada una de las diez alternativas. En caso de que se elija una respuesta incorrecta, el ser humano o la IA la descartarán e intentarán otra y, finalmente, la solución se encontrará en nueve pasos o menos. Sin embargo, parece que ChatGPT se desvía de encontrar la solución al incorporar nuevos datos en cada nueva respuesta, que no estaba entre las posibles opciones de solución.

Creo que podemos concluir que los sistemas basados en Large Language Model son una tecnología de Inteligencia Artificial poderosa y fascinante con resultados sorprendentes que sin duda nos seguirán sorprendiendo. Sin embargo, creo que es arriesgado considerar que estos sistemas tienen conciencia o inteligencia general. Es crucial recordar que existen muchas otras técnicas de IA que podemos utilizar para desarrollar sistemas inteligentes. La combinación de varios métodos puede conducir a mejores sistemas inteligentes que pueden ayudar a resolver problemas que requieren inteligencia y benefician a la humanidad. No obstante, es esencial enfatizar que todas las técnicas de IA, incluido LLM como ChatGPT, deben priorizar el enfoque humano y ser reguladas para garantizar principios éticos. La Inteligencia Artificial Responsable tiene un papel importante que desempeñar en el campo de la IA en general y en el área de LLM, como ChatGPT, en particular.

Es arriesgado considerar que estos sistemas tienen conciencia o inteligencia general